Comment caractériser et évaluer les attributs de Confiance de l’IA ?

S’appuyant sur différentes sources, (normes, standards, communications scientifiques, états de l’art réalisés dans le programme Confiance.ai…), les travaux de caractérisation et évaluation des attributs de confiance portent sur la définition, la structuration et les métriques des attributs constitutifs de la confiance dans le cadre du déploiement de l’IA dans les systèmes critiques.

Ces attributs sont aujourd’hui regroupés en fonction des capacités qu’ils caractérisent : la technique, l’éthique, l’interaction et les intermédiaires de la confiance (comme la certification). La technique est considérée comme la capacité de vérifier que le composant à base d’IA est valide et robuste. Cela regroupe donc des attributs comme la fiabilité (reliability, dependability), la précision, la reproductibilité ainsi que la maintenabilité. L’éthique, fortement liée en Europe à la notion des droits fondamentaux, est notamment mise en avant dans les travaux de l’AI HLEG (High-Level Expert Group on Artificial Intelligence) de la Commission Européenne. Un système doit par exemple offrir une garantie d’équité (fairness) ou le respect de la vie privée (privacy). L’interaction avec les parties prenantes (utilisateurs finaux, concepteurs et auditeurs) est liée aux notions de transparence, d’explicabilité ou encore d’usabilité. Enfin, les attributs pour intermédiaires d’écosystèmes de confiance s’intéressent aux activités d’assurance qualité, d’audit et de certification. L’ensemble de ces propriétés sont traduites au niveau de la qualité des données.

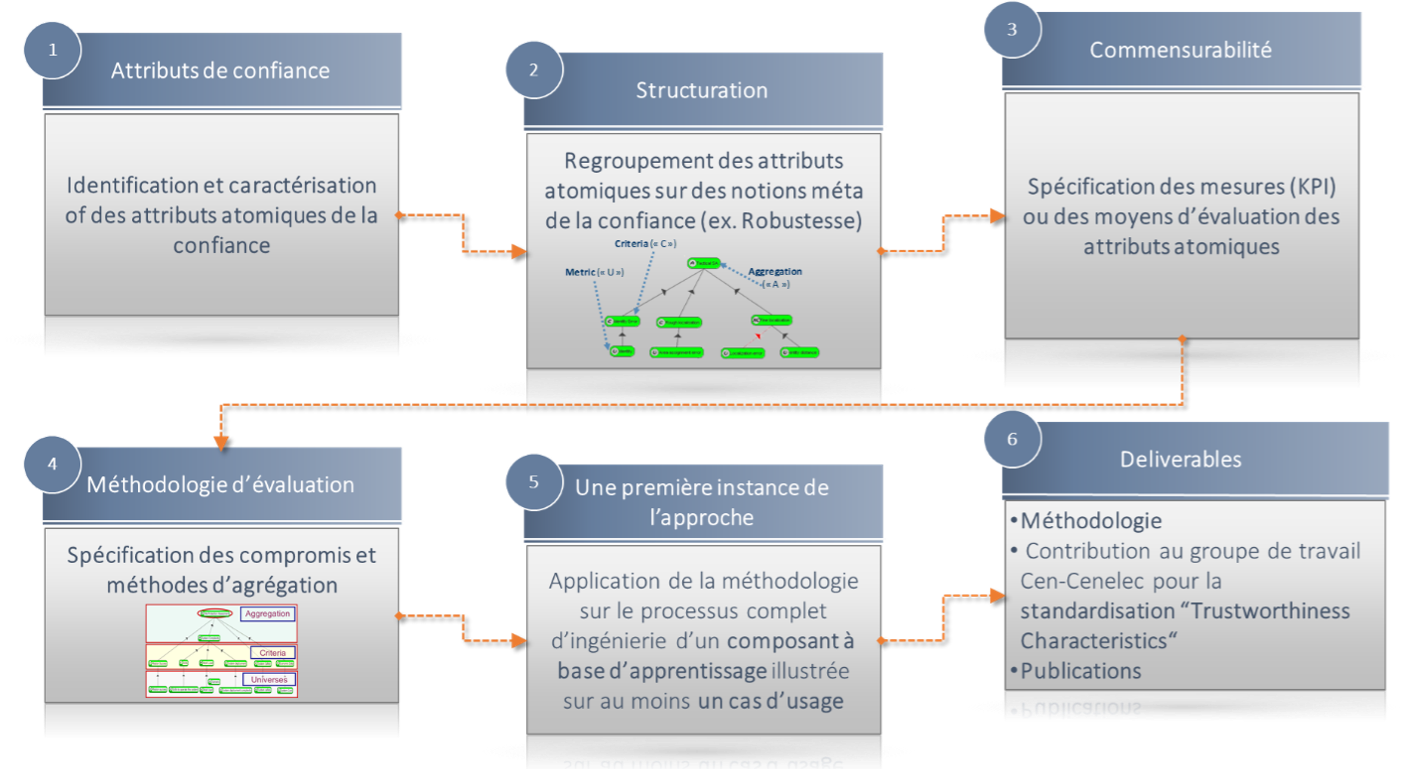

Figure 1 : Méthodologie de construction et d’évaluation des attributs de confiance

L’approche repose sur les étapes suivantes :

- Définitions des différents attributs constitutifs à la confiance (Confiance.ai a déjà identifié 128 attributs élémentaires) ;

- Structuration des attributs dans un arbre sémantique permettant une première hiérarchisation avec une mise en valeur de concepts comme la robustesse, l’explicabilité, la qualité des données ;

- Identification de métriques, de méthodes d’évaluation ou de points de contrôle pour les attributs atomiques ;

- Définition d’une méthodologie d’agrégation pour permettre de capturer les compromis opérationnels et d’évaluer des attributs de plus haut niveau

- Cette étape a pour objectif la confrontation de la méthodologie dans un premier temps au domaine de l’apprentissage automatique avec une illustration sur un cas d’usage du programme.

Ces travaux permettent d’alimenter les réflexions menées dans le groupe de travail de normalisation européenne « Approche unifiée globale sur les caractéristiques de la confiance » piloté par le LNE (Laboratoire National de Métrologie et d’Essais) et l’IRT SystemX. Le groupe de travail a pour objectif de définir le périmètre et la structure du standard européen qui permettra aux industriels de comprendre :

- Les caractéristiques fondamentales de la confiance au sens du futur Règlement européen pour l’IA (IA act)

- Les méthodes et métriques nécessaires pour estimer la conformité de leurs systèmes aux exigences liées à la confiance.

Ces travaux se font au sein du CEN-CENELEC, un organisme où sont développés les standards européens (préfixés « EN ») qui sont ensuite obligatoirement traduites en normes nationales (par exemple préfixées « EN FR » par l’AFNOR en France). Si le respect des standards est de manière générale volontaire, certains standards européens dits harmonisés, sont d’autant plus importants qu’ils offrent une présomption de conformité à la réglementation européenne. En d’autres termes, ils présentent une manière claire et concrète de respecter la loi. Le CEN-CENELEC peut adopter des standards développés au sein de l’ISO, un organisme de standardisation international et le CEN-CENELEC et l’ISO peuvent aussi développer des standards de manière conjointe.

Le programme Confiance.ai présente l’avantage d’adopter un point de vue cohérent avec celui de l’AI Act : on y considère les différentes caractéristiques de la confiance de manière transverse, dans différents secteurs d’application. Confiance.ai présente aussi l’avantage d’offrir le point de vue consolidé d’une variété de partenaires : ses résultats ont ainsi d’autant plus de valeur dans une démarche de standardisation. Les organismes de standardisation peuvent inclure encore davantage de parties prenantes, y compris par exemple des associations de consommateurs ou des organisations non-gouvernementales.

La standardisation des différentes caractéristiques de la confiance présente différents défis. D’abord, elle doit être appréhendable par des entreprises de nature et de taille très différentes. Elle doit aussi bien sûr permettre d’y préserver l’innovation. Le plus grand défi est peut-être lié au calendrier de l’AI Act. Il est souhaité que les standards liés à l’AI Act soient terminés à horizon 2024, lorsque l’AI Act sera appliqué. Or, le développement d’un standard peut souvent prendre davantage de temps, notamment sur des sujets aussi complexes que les caractéristiques de la confiance pour un système à base d’IA. L’AI Act peut d’autre part encore évoluer dans les mois qui viennent.

Le groupe de travail de normalisation européenne « Approche unifiée globale sur les caractéristiques de la confiance » s’est d’abord concentré sur l’identification des initiatives pertinentes traitant d’IA de confiance (normes, travaux européens). Il s’est ensuite concentré sur la manière de structurer la future norme, en identifiant les manques pouvant substituer pour certaines caractéristiques de confiance.

Un article rédigé conjointement par Agnès Delaborde, Henri Sohier et Juliette Mattioli